GeoAI: Ist Intelligenz räumlich?

Dieses Semester stellten wir uns die Frage „Wissen wir, was KI wissen wird?“. Und auch wenn KI-Systeme noch nicht wissen, können sie Dinge darstellen, nachbilden und Schlussfolgerungen aufstellen. Interessanterweise sind diese Schritte zutiefst geografisch oder zumindest räumlich geprägt. Lassen Sie mich erklären, weshalb das aus Sicht der GeoAI-Forschung relevant ist.

Was ist GeoAI?

Das interdisziplinäre Feld GeoAI (Geospatial Artificial Intelligence) kombiniert Geografie, Geowissenschaften, Kognitionswissenschaft und Informatik. Es untersucht, wie die drängenden Herausforderungen in der Geografie und den Geowissenschaften mithilfe von KI-Technologien behandelt werden können. Darüber hinaus beschäftigt es sich damit, wie räumliches Denken und räumliche Analysen dazu beitragen können, die Leistungsfähigkeit von KI bei Aufgaben zu verbessern, die nicht explizit geografisch sind. Damit leistet GeoAI auch einen wichtigen Beitrag für die breitere KI-Community. GeoAI kommt unter anderem im Katastrophenschutz, im Gesundheitswesen, in Biodiversitätsstudien, bei Verkehrsprognosen und bei Vorhersagen zur Kriminalität zum Einsatz. Sie wird aber auch eingesetzt, um geografische Biases in KI-Systemen zu entdecken und abzuschwächen. Der folgende Beitrag geht darauf ein, wie der geografische Raum bestimmt, was KI weiß, und weshalb das relevant ist.

Die linguistischen Wurzeln von KI

Um effizient mit uns kommunizieren zu können, brauchen KI-Systeme Sprachmodelle und relevante Informationen für die Diskussion. Die heutigen Sprachmodelle fußen auf einer sprachwissenschaftlichen Theorie der 1950er Jahre, die besagt, dass Wörter, die in ähnlichen Kontexten vorkommen, eine ähnliche Bedeutung haben. Die neuesten Systeme haben jedoch nicht nur mit Größe zu tun – wenngleich der allgegenwärtige Begriff „Large Language Model“ (LLM) den Anschein erweckt – sondern vielmehr mit der Fähigkeit dieser Modelle, den dynamischen Charakter von Sprache darzustellen, in der Bedeutung (Semantik) im Gespräch entsteht und kontextabhängig ist.

Als die ersten KI-Chatbots auf Basis dieser neuen (LLM-)Systeme vorgestellt wurden, fußten diese fast ausschließlich auf den Trainingsdaten, mit denen sie gefüttert wurden. Dies führte häufig zu Halluzinationen, d.h. die Chatbots erfanden Fakten, präsentierten oft absurde Ergebnisse und konnten zudem nur auf Informationen zur Vergangenheit zugreifen, also auf Informationen in ihren Trainingsdaten.

Daten statt Träume

Daher kommen bei den aktuellen KI-Systemen verschiedene Formen der Augmentation, d.h. Transformationen bereits vorhandener Trainingsdaten, zum Einsatz. Wenn die Frage eines Nutzers/einer Nutzerin beispielsweise die Lösung eines numerischen Problems erfordert, wie z.B. die Einschätzung, wie sich die Bevölkerungsdichte und die Immobiliennachfrage in Wien bis 2030 entwickeln werden, übersetzen KI-Systeme die relevanten Teile zunächst in eine Programmiersprache. Als Nächstes führen sie ihren selbst geschriebenen Code aus, generieren die Ergebnisse und integrieren sie nahtlos in das Gespräch. Folglich können wir jetzt mit einer tatsächlichen Bevölkerungsprognose rechnen, die aus einer seriösen Quelle stammt, während KI-Chatbots uns früher im Brustton der Überzeugung eine erfundene Zahl auftischten. Diese Art der Augmentation wird als Retrieval-Augmented Generation (RAG) bezeichnet: Bevor sie antwortet, ruft die KI zuerst relevante Informationen aus vordefinierten Quellen ab.

Wissen ist räumlich und zeitlich

Was wie eine technische Feinheit klingen mag, hat es in sich. Die Bedeutung der in diesen Datenquellen verwendeten Terminologie, wie „Wasserstand“, oder „Immigrant*in“, wird (implizit) während ihrer Generierung festgelegt und bleibt danach statisch. Dazu gehören auch viele andere Metadateneigenschaften, die die zukünftige Wiederverwendung des Datensatzes steuern. Gerade diese Diskrepanz zwischen statischer Datensemantik und der fließenden, kontextabhängigen Bedeutung im menschlichen Diskurs hat die Wiederverwendbarkeit von Daten seit den Anfängen von Daten geplagt und stellt KI-Systeme heute zunehmend vor Herausforderungen. Der Begriff „Hochwasserrisiko“ beispielsweise könnte sich in einem Hypothekendatensatz auf eine eng definierte langfristige Wahrscheinlichkeit erheblicher Sachschäden beziehen. In einem zwanglosen Gespräch könnte er jedoch auch bedeuten, dass Starkregen eine unmittelbare Gefahr für das Zuhause einer Person bedeutet.

Wie umgehen mit der Vielfalt von Daten und Definitionen?

Wirklich interessant wird es, wenn wir eine räumliche und zeitliche Komponente hinzufügen. Bisher haben wir den kulturellen und ökologischen Kontext, in dem eine Diskussion stattfindet oder Daten erstellt werden, der Einfachheit halber ignoriert. Wir haben mit der Zeit gelernt anzunehmen, dass sich Begriffe wie Freiheitskämpfer*in, Geschlecht und Migration je nach Zeit und geografischem Raum, z. B. von Land zu Land, erheblich unterscheiden. Das Gleiche gilt jedoch auch für viele scheinbar objektive Begriffe und sogar für wissenschaftliche Terminologie. So gibt es beispielsweise mehrere hundert verschiedene und oft rechtlich bindende Definitionen von „Wald“ oder „Stadt“. Diese Variabilität erschwert die Untersuchung vieler dringlicher gesellschaftlicher Fragen, wie etwa der klimabedingten Migration maßgeblich. Human Data Scientists nutzen bis zu 80 % der Ressourcen eines Projekts, um solche Datenprobleme in einem Prozess zu bewältigen, der als Data Wrangling bezeichnet wird und darauf abzielt, Daten in Form zu bringen. KI kann das – noch – nicht.

Derzeit sind Wissensgraphen (Knowledge Graphs) einer der erfolgversprechendsten Kandidaten, um die KI-Kompatibilität von Daten zu verbessern. Im Gegensatz zu typischen Dateninfrastrukturen, die lediglich den Zugriff auf Daten verwalten, sind diese Diagramme großräumige Strukturen, in denen Milliarden einzelner Einheiten aus sehr heterogenen Quellen, die Orte, Personen, Objekte und Ereignisse beschreiben, eng in einer Form miteinander verknüpft sind, die von Menschen und Maschinen gelesen werden kann. Ein Beispiel eines solchen Diagramms ist unser KnowWhereGraph. Er besteht aus über 40 Milliarden Aussagen (Fakten, sozusagen) aus mehr als 30 miteinander verknüpften Datenschichten, von Daten zu Gesundheit und Bevölkerung, Infrastruktur, Orten, Klimavariablen, Kulturen und Bodenqualität bis hin zu Daten zu extremen Ereignissen wie Erdrutschen und deren Folgenabschätzungen.

KnowWhereGraph zielt darauf ab, innerhalb von Sekunden geografische Zusammenfassungen zu jedem Ort der Erde zu liefern, um der KI das kontextuelle Hintergrundwissen zur Verfügung zu stellen, das sie braucht, um Fragen zu beantworten anstatt Ergebnisse herbeizuträumen. Während viele kommerzielle KI-Systeme ihre eigenen Unternehmensgraphen nutzen, greifen andere auf das Schwesterprojekt von Wikipedia zurück – Wikidata. Diese Diagramme liefern derzeit die Daten, die für Retrieval-Augmented Generation (RAG) benötigt werden.

Vor diesem Hintergrund sollte es für einen KI-Chatbot doch ein Leichtes sein, die Anzahl der Einwohner*innen Wiens auf Anfrage von Nutzer*innen abzurufen, aber dem ist nicht so. Diese überraschende Tatsache beruht darauf, dass es Dutzende konkurrierender Bevölkerungszahlen gibt: Regierungsstatistiken, statistische Schätzungen, Schätzungen Dritter, Statistiken über (Kern-)Städte und Metropolregionen, usw. Allein Wikipedia führt Dutzende Bevölkerungszahlen für Wien an, z.B. je nach Sprachversion. Mit welcher Zahl soll eine KI nun arbeiten? Im Moment priorisieren menschliche Entscheidungsträger im Hintergrund die Datenquellen.

Verzerrte Daten, verzerrte Darstellung

Die Antwort auf diese Frage findet sich wieder einmal in der Geografie. Es stellt sich heraus, dass unser Wissen über Orte, Kulturen, Menschen und Ereignisse nach seinem Grad an Lokalbezug variiert. Einfach ausgedrückt, kommen die meisten Informationen, die LLM und RAG über die Vereinigten Staaten zur Verfügung stehen, aus den USA. Dies ändert sich jedoch rasch, wenn wir den globalen Süden, Asien und sogar Teile Europas betrachten. Für viele dieser Länder kommen die meisten Informationen, z.B. Webseiten, nicht aus den Ländern selbst sondern ebenfalls aus den USA, Frankreich und einigen anderen Ländern. Würden Sie für unser Beispiel zur Bevölkerungszahl Wiens der deutschen Wikipedia-Version mehr vertrauen (da sie vermutlich eher von Einheimischen geschrieben wurde) oder der englischen, internationalen Version?

Noch besorgniserregender sind Statistiken, die die geografische Verteilung von Bildern für das Training von KI-Modellen beschreiben, die Bilder aus Text generieren. Bei einem beliebten Datensatz stammen beispielsweise nur 3 % der Bilder aus China und Indien. Die große Frage ist nun, ob das wichtig ist. Unsere aktuellen Forschungen zeigen, dass dem so ist. "Geographie nach ChatGPT" spiegelt nicht immer wahrheitsgemäß lokale Heterogenität wider. Da wir immer mehr durch die Augen von KI-Systemen über die Welt um uns herum erfahren werden, ist es problematisch, wenn eine Bilder-KI immer ein Bild der Appalachen erzeugt, wenn sie nach einem Berg gefragt wird, und nie eines vom Kilimandscharo.

Sowohl die Industrie als auch die Forschung sind sich dieser und anderer Biases bewusst. Allerdings ist das Debiasing keine objektive Aufgabe, zumal unklar ist, ob KI zeigen soll, was ist oder ob es zeigen soll, was wir anstreben. Google beispielsweise musste kürzlich öffentlich eingestehen, dass es im Versuch die Ergebnisvielfalt seines KI-Systems zu erhöhen „am Ziel vorbeigeschossen war“ – seine KI stellte auch schwarze und asiatische Nazi-Soldaten dar. Im Idealfall sollte die Frage, wie LLM mit den gesellschaftlichen Zielen in Einklang stehen soll, im demokratischen Konsens getroffen werden und nicht hinter geschlossenen Türen und mithilfe undurchschaubarer Technologien. Andernfalls laufen wir Gefahr, das erste ‚L‘ in LLM von "Large" in "lügend" zu verwandeln. Für die Beantwortung unserer ersten Frage „Wissen wir, was KI wissen wird?“ müssen wir uns zunächst also auch fragen: „Wissen wir, was die Ingenieur*innen wissen, denen wir das Debiasing von KI anvertraut haben?“

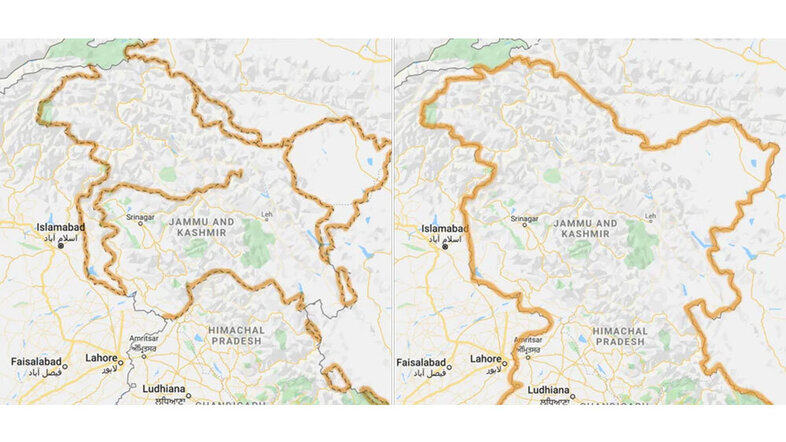

Schließlich lohnt es sich auch zu fragen, was Wahrheit im Kontext von KI bedeutet. Sie sind jetzt sicherlich nicht überrascht, wenn ich Ihnen sage, dass auch die Wahrheit eine räumliche und zeitliche Dimension hat. Ob eine Aussage wahr ist, hängt davon ab, wann und wo etwas gesagt wurde. Bekanntermaßen gibt Google Maps – je nachdem ob man in Indien oder in Pakistan reist – unterschiedliche Karten der Region Kaschmir aus, da die Grenzen umstritten sind. Folglich hängen die "Fakten" zur Gesamtfläche oder Bevölkerung dieser Länder auch davon ab, wo Sie sich befinden, wenn Sie diese Fragen stellen. Welche Antwort erwarten wir von einer KI? Oder sollte es viele lokale KI-Versionen geben? Daten über die Welt sind nicht widerspruchsfrei, und diese Widersprüche sind keine Datenfehler, sondern spiegeln die Unterschiede in örtlichen Kulturen, Bräuchen und Gesetzen wider.

Um zu wissen, was KI wissen wird, müssen wir verstehen, wie KI die Welt um uns herum darstellt und gleichzeitig die geografischen, kulturellen und zeitlichen Kontexte der Trainingsdaten berücksichtigen, auf die sie Zugriff hat.